Я уже писал про выход новой прошивки для систем Xyratex 5412/6412 и уже несколько раз возникали вопросы, как же нужно прошивать. Так что сегодня огромный пост будет про, на мой взгляд, самый большой недостаток этих дисковых систем – а именно про процедуру обновления firmware. Почему недостаток? А потому как процедура эта многоступенчатая, требует внимательности и осторожности. А, помимо прочего, требует еще и остановки системы (а, как следствие и всех приложений, которые с ней работают). Конечно, обновление прошивок дисков и в других системах потребует прервать ввод-вывод, но обычно все-таки действий нужно делать меньше. Итак, если Вам нужно обновить прошивку, то запланируйте downtime заранее. Если обновлять будете еще и прошивки на дисках, то учтите, что время простоя заметно возрастет – диски обновляются по-одному и если их 60 штук, то времени уйдет порядком. Что нам потребуется?

- Ноутбук или ПК, с которого и будем все обновлять. Обязательное условие – наличие последовательного порта! Стандартный кабель подключается к 9-пиновому разъему, возможно потребуется переходник.

- Кабель для последовательного порта, который скорее всего был в комплекте поставки (хотя это зависит от того, как была куплена система). Номер для заказа: RS-CAB-2M-RS232-USB.

- Программа для работы в терминале (либо стандартный HyperTerminal, либо что-то еще с поддержкой протокола 1K X-Modem для передачи файлов).

- Ну и конечно, необходимо иметь возможность подключиться к системе также и через локальную сеть.

Всего существует 5(!) различных прошивок (указаны в том порядке, в котором нужно обновлять):

- прошивка модуля Disk I/O (это тот, который установлен в полках расширения)

- boot PROM контроллера

- прошивка самого контроллера RAID

- прошивка StorView (система управления)

- прошивка жестких дисков

Порядок обновления важен и рекомендуется его соблюдать чтобы избежать лишних и ненужных проблем.

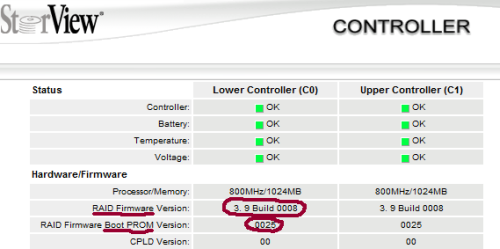

Подготовили все необходимое. Сделали очередную резервную копию. Выключили серверы (или отмонтировали на серверах тома, находящиеся на дисковой системе). И только после этого начинаем. Первым делом убеждаемся, что система работает нормально, нет ни “вылетевших” дисков, массивы не находятся в состоянии перестроения и не происходят никакие другие чудеса. Затем следует определиться с тем, что нужно обновлять, а что – нет. Если кроме контроллерного модуля ничего нет, то прошивку Disk I/O пропускаем так как их физически нет. Текущую версию boot PROM можно увидеть в StorView, нажав мышкой на любой из контролеров:

Версию StorView можно узнать, нажав на кнопку ABOUT в правой верхней части основного окна (впрочем, версию StorView все равно обновлять придется практически наверняка):

1. Прошивка модуля Disk I/O.

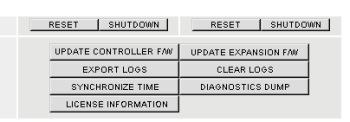

Если система не имеет модулей расширения (или их прошивки обновлять не требуется), то переходим к следующему пункту. Если система одноконтроллерная, то задача упрощается и мы сразу приступаем к прошивке: заходим в утилиту управления (StorView) через любой браузер (с отключенной блокировкой всплывающих окон) на адрес http://ip-address:9292/ (ip-address это очевидно адрес нашего единственного контроллера). Нажимаем на иконку Controller 0&1:

В открывшемся окне нажимаем кнопку UPDATE EXPANSION F/W.

Загружаем файл, ждем завершения. Первый этап закончен.

Если же система двухконтроллерная, то действий потребуется больше: необходимо сначала физически извлечь из системы один из RAID-контроллеров (из “головной” полки) – действуем, как было описано выше, но вместо UPDATE EXPANSION, делаем SHUTDOWN одному из контроллеров, а затем физически его извлекаем. После этого выполнить процедуру прошивки (как описано выше). Выключаем “головной” модуль, устанавливаем обратно вытащенный контроллер, а второй извлекаем. Включаем систему и повторяем процедуру обновления. Обратите внимание, что не нужно ничего вытаскивать из модулей расширения и выключать их также не нужно! Важно: прошивка занимает время, но статус ее через web-интерфейс отследить нельзя – только по индикаторам на системе. Так что лучше подождать и никуда не торопиться.

2. Прошивка boot PROM контроллера.

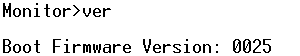

Вот здесь нам понадобится подключение к последовательному порту. На счастье boot PROM обновляется не так часто. Для двухконтроллерных систем, как и прежде, потребуется извлечь один из контроллеров, так что этот этап можно совместить с первым (чтобы два раза не дергать контроллеры). Оставив один контроллер, подключаемся к нему через терминальную программу. Стандартные установки порта 115200-8N1. Включаем систему, и несколько раз нажимаем на Enter (до того, как что-то появится на экране), чтобы попасть в “Monitor” (специальная утилита, которая загружается еще до Firmware контроллера). Еще раз проверить версию boot PROM можно, набрав команду ver (ниже, кстати, будет указана и модель контроллера чтобы не ошибиться):

3. Прошивка контроллера RAID.

Неприятные процедуры практически закончились. Теперь проверяем, что оба контроллера установлены и все кабели (к дисковым полкам) подключены – их отключать и не нужно было, но лучше бы проверить. Включаем систему и после этого заходим в StorView (через барузер). Проверяем, что все компоненты определились и ошибок нет. Нажимаем на иконку Controller 0&1, а там на кнопку UPDATE CONTROLLER F/W, отправляем файл с прошивкой и ждем около трех минут. За это время оба контроллера будут прошиты. Проверить успешность процедуры можно еще раз нажав на Controller 0&1 и посмотрев версию.

4. Прошивка StorView

Находясь в StorView, нажимаем на кнопку About (вверху справа):

После сообщения об успешной прошивке можно переходить к прошивке StorView на втором контроллере – вновь подключаемся по IP (уже к другому контроллеру) и повторяем все действия.

5. Прошивка жестких дисков.

И на сладкое осталась не самое приятное и, пожалуй, самое опасное – прошивка жестких дисков. Для этого нам опять потребуется доступ через последовательный порт. Для двухконтроллерной системы второй контроллер необходимо отключить (можно не вытаскивать, а просто сказать ему SHUTDOWN в окне Controller 0&1). После этого, привычным жестом подключаемся через терминал. Нажимаем Ctrl-E, чтобы вызвать меню:

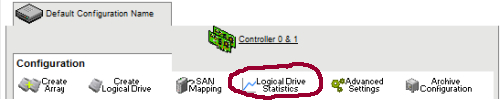

Все! После этого остается зайти в StorView по IP и проверить что все запустилось. Если все удалось, то нажимаем Controller 0&1 и там нажимаем на кнопки CLEAR LOGS и SYNCHRONIZE TIME. Затем на основном окне нажимаем Logical Drive Statistics:

И там нажимаем кнопку CLEAR.

Вот теперь действительно все обновили! Можно подключать серверы обратно и работать.

Процедура, как я и обещал, длинная и непростая. Но если варианта “свалить” работу на кого-то еще нет, то придется делать, а я постарался все описать максимально подробно.

Читать дальше ...