вторник, 1 августа 2017 г.

История про интеграцию Unity 400F, Wabi-Sabi и гонке на ¼ мили.

среда, 14 декабря 2011 г.

Одной строкой

Обновилась камасутра библия для владельцев систем NetApp и IBM N-series – документ с говорящим за себя названием “NetApp Storage Best Practices for VMware vSphere” (TR-3749). Основные изменения коснулись возможностей vSphere 5. Скачать можно совершенно свободно, даже регистрация не требуется. Всем, кто использует VMware, документ обязательно нужно прочитать хотя бы один раз!

Для серверов IBM x3650M3 и x3550M3 анонсирован новый RAID контроллер – ServeRAID M5016. Ключевая особенность – наличие 1GB кэш памяти с защитой, но не батарейкой, а флэш-памятью с конденсаторным модулем (ну наконец-то уже!). Для активации RAID6/60 более не требуется дополнительный ключ – все работает “из коробки”.

Предвосхищая – модуль с конденсаторами на фото не показан, он “болтается” отдельно, пристегнутый длинным кабелем к контроллеру (примерно как с использованием Remote Mount Cable на M5015).

Читать дальше ...пятница, 11 февраля 2011 г.

VMware vSphere 4.1 Update 1

Вчера вышел первый апдейт к версии 4.1 ESX/ESXi и vCenter Server. Ключевых изменений практически нет – в основном исправления ошибок и поддержка новых операционных систем Windows7 SP1 и Windows Server 2008R2 SP1, а также RHEL 5.5 и 6.0. Для vCenter теперь есть поддержка MS SQL 2008R2 и IBM DB2 9.7.2 (как бесплатной Express C, так и Enterprise). ESX/ESXi теперь умеют поддерживать до 160 логических процессоров.

Более подробная информация о релизе на сайте VMware:

- VMware ESX 4.1 Update 1 Release Notes

- VMware ESXi 4.1 Update 1 Release Notes

- VMware vCenter Server 4.1 Update 1 Release Notes

четверг, 16 декабря 2010 г.

Планирование VMware High Availability

VMware на днях опубликовали краткий, но довольно полезный документ про то как нужно планировать HA: “VMware High Availability (HA): Deployment Best Practices”. Хотя, по большому счету, никаких тайных знаний там не содержится, но прочитать хотя бы один раз настоятельно рекомендуется (особенно тем, кто только планирует развернуть у себя инфраструктуру).

Читать дальше ...четверг, 14 октября 2010 г.

VMware SRM – снижаем требования к полосе пропускания

Случайно наткнулся на интересную заметку в блоге Dave Lawrence про то как лучше настроить VMware SRM, чтобы сократить требования к полосе пропускания между площадками. Вкратце: стоит ли настраивать репликацию дисков со swap-файлами? По логике конечно нет – раз уж даже в официальных документах VMware рекомендуется не реплицировать диски со swap файлами VM, то уж своп виртуальных машин точно не нужен. Известны случаи, когда в результате отказа от репликации файла подкачки, удавалось сократить трафик на 80%! Подробное описание можно найти вот в этом документе NetApp: VMware vCenter Site Recovery Manager in a NetApp Environment. Основная хитрость состоит в том чтобы на удаленной площадке для каждой VM оказался нереплицируемый диск с правильной сигнатурой (иначе при рестарте VM диск получит другую букву и мы столкнемся с очевидными проблемами).

Читать дальше ...вторник, 20 июля 2010 г.

Что запомнить, а что забыть…

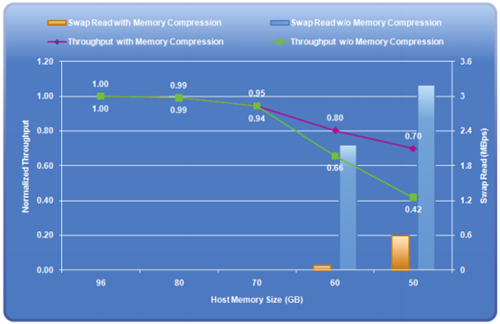

Помимо различных замечательных возможностей в работе с дисковыми устройствами, в версии vSphere 4.1 несколько изменилась и работа с оперативной памятью – появилась функция “Memory Compression” (сжатие страниц-кандидатов на попадание в своп), которая в определенных случаях может заметно помочь. Срабатывает она только в моменты “перенасыщения” памяти (over-commintment), поэтому на нормальную работу (мы же не будем специально загонять себя в такой режим?!) она не влияет, но как только появляется потребность сбросить страницы в своп на диске (рис b), начинает работать memory compression. Обоснование ее использования состоит в том, что процедура распаковки сжатой страницы из специально отведенного пула (рис c) займет гораздо меньше времени, чем “вытаскивание” ее из своп-файла на диске:

Подробности можно прочитать (с картинками, но без диалогов) в соответствующем обновленном документе от VMware. Там же есть и некоторые результаты тестов. В частности, показано как memory compression улучшает результат Swingbench (вернее снижает степень его деградации при перенасыщении памяти):

пятница, 16 июля 2010 г.

Чем померить виртуализацию?

Попытки сделать стандартный тест (бенчмарк) для систем виртуализации делались уже давно, но единого общего знаменателя я не встречал. VMware использует свои попугаи, остальные стараются как-то выкручиваться. Плюс были попытки создать независимые бенчмарки, но как-то пока никто не прижился.

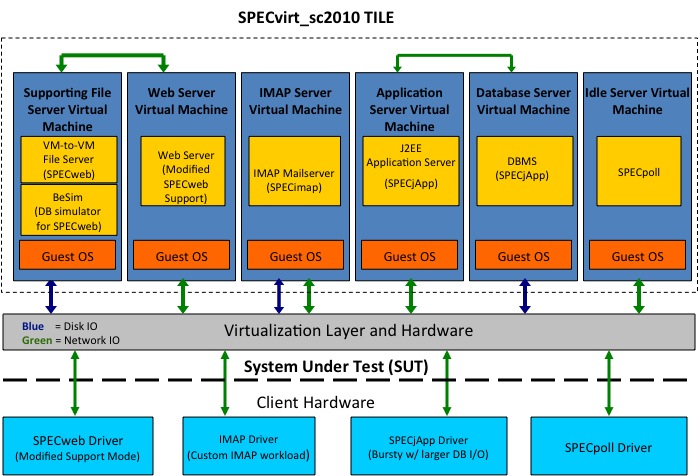

Но вот 14 июля сего года небезызвестный SPEC запустил свой бенчмарк для виртуализации - SPECvirt_sc2010. Основан он на целом ряде других тестах SPEC – SPECweb2005, SPECjAppserver2004, SPECmail2008. В виртуальной среде создается “инфраструктура” из нескольких VM, в которых и выполняется набор тестов:

Таких “инфраструктур” (Tile) на одном сервере может быть запущено несколько и как раз это показывает насколько хороша масштабируемость:

Результаты бенчмарка отображаются в виде <Overall_Score> @ <6*Number_of_Tiles> (т.е. после символа @ идет суммарное число VM, запущенных на хосте).

Подробнее про схему бенчмарка можно прочитать здесь.

Хочется верить, что выход в свет SPECvirt_sc2010 позволит немного более предметно проводить сравнения и гипервизоров, и железа.

На текущий момент в тестах наметился уверенный лидер – IBM с сервером x3650M3 и KVM в качестве гипервизора (результат 1169 @ 72). Во многом правда это лидерство обеспечено тем, что на сегодня это и единственный опубликованный результат :)

Читать дальше ...четверг, 13 мая 2010 г.

Убийца SVC где-то рядом?

Еще один уверенный шаг EMC в сторону концепции IT as a Service сделан. Под брызги шампанского и бурные овации на EMC World 2010 анонсирован VPLEX. Выбранное имя конечно не удивляет – сейчас продукт, в названии которого не будет буквы “V”, могут представить только аутсайдеры (даже если к виртуализации никакого отношения продукт и не имеет, а здесь-то как раз виртуализация на месте). Прозвучали и громкие слова “Storage federation”. VPLEX преподносится как таблетка от всех проблем, связанных со сложностью администрирования разрозненных “островков” систем хранения. Казалось бы, что нового? Все это уже давно есть и у IBM (SVC), и у HDS (USP-V), и даже у самой EMC (Invista) – системы виртуализации СХД уже не первый год на рынке.

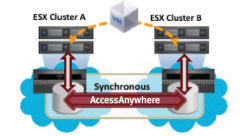

Но, как и всегда, есть несколько “но”. В настоящее время VPLEX поставляется только в двух вариантах – VPLEX Local (для работы на одном сайте) и VPLEX Metro (для объединения двух площадок, расстояние между которыми позволяет использовать синхронную репликацию, т.е. до 100км). В первом случае решение ничем не отличается от любой другой системы виртуализации СХД, во втором конечно есть отличия, но и здесь конкурентам есть что предложить. Справедливости ради нужно сказать, что в перспективе EMC обещает еще две версии VPLEX – Global, для объединения двух площадок на расстоянии более 100км (асинхронная репликация) и VPLEX Geo, который уже позволит объединять несколько датацентров на произвольном расстоянии друг от друга. Все это, однако, ждет нас не раньше 2011 года. Кроме того, функционал VPLEX в плане виртуализации также довольно ограничен на текущий момент – поддерживаемые “чужие” СХД (IBM, HDS) можно пересчитать на пальцах одной руки (список конечно планируют еще расширять); нет поддержки ни thin provisioning, ни мгновенных снимков – если это необходимо, то придется пользоваться функционалом СХД. Собственно, из-за этого скорее всего и не было объявлено о смерти Invista. Картина становится несколько мрачнее – в настоящий момент VPLEX для большинства не принесет долгожданной простоты управления, а скорее добавит сложностей. Нужно будет не только научиться управлять VPLEXом, но и продолжать следить за виртуализированными СХД и, возможно, гораздо аккуратнее заниматься выделением пространства, так как теперь между СХД и серверами окажется новое устройство, которое будет усложнять представление данных.

Итак, анонс прошел, фанфары прозвучали, что в сухом остатке? Отношение неоднозначное. Сказать, что EMC “стрельнули” уникальным продуктом я не могу. Вот если бы все это было реализовано на базе VMAX, это было бы действительно “круто”! Концептуально предложенное решение мне, впрочем, и так нравится. Но вот что не нравится: отсутствие кэша на запись, отсутствие таких функций как thin rpovisioning, снимки, клоны и т.п. Сейчас можно говорить лишь только об озвученном плане на будущее развитие. План радужный, но насколько он будет воплощен в жизнь остается под вопросом. А пока заказчикам остается выслушивать истории про Storage Federation и IT as a Service ну и конечно про Cloud Computing. Впрочем, если вдруг прямо сейчас нужно взять и начать строить (именно начать) пресловутое облако, то возможности VPLEX могут оказаться востребованы. Для двух площадок можно даже обойтись и без VMware SRM, продолжая обеспечивать высокий уровень доступности сервисов. Так что заказчики на VPLEX безусловно найдутся, но сможет ли он серьезно потеснить IBM SVC (или хотя бы HDS) на рынке систем виртуализации – большой вопрос. И на сегодняшний день мой прогноз – в ближайший год шансов очень и очень мало.

Читать дальше ...среда, 24 марта 2010 г.

В помощь виртуальным и отказоустойчивым :)

Вышла очередная книжка за авторством Mike Laverick, посвященная работе с VMware Site Recovery Manager (SRM). В книге очень подробно и с многочисленными примерами рассказывается о том, как и что можно делать в версии SRM 4.0. Примеры включают в себя не только непосредственно работу с SRM, но и настройку таких систем хранения как EMC Celerra и Clariion, NetApp FAS и HP LeftHand. Самый главный минус для российских читателей – книга на английском языке, впрочем это, к счастью, для многих не самая большая сложность.

Читать дальше ...понедельник, 18 января 2010 г.

Полезное чтиво про IBM DS4000/DS5000

IBM опубликовал сразу 4 драфта новых книжек про системы хранения среднего уровня (DS4000/DS5000), которые должны занять достойное место в подборке документации администраторов СХД:

- IBM Midrange System Storage Hardware Guide

- IBM Midrange System Storage Implementation and Best Practices Guide

- IBM Midrange System Storage Copy Services Guide

- VMware Implementation with IBM Midrange System Storage

По сравнению с тем, что уже можно было найти в “редбуках” ранее, собрана вместе информация по новым системам в линейке DS4000/DS5000 и подробно описаны все нововведения. Две последние работы довольно узко специализированы: в одной подробнейшим образом изложен механизм работы мгновенных снимков и клонирования (в т.ч. и между системами), а вторая посвящена виртуализации на базе VMware ESX/ESXi. В принципе, обе книги не содержат радикально новой информации (по крайней мере, я не увидел ничего, что не встречалось бы в выпущенной ранее документации), однако прочитать и держать под рукой эти материалы полезно. Тем же, кто впервые развертывает VMware на системах IBM DS4000/5000 читать просто необходимо – в соответствующей книге собран вместе обширный материал, который позволит гораздо лучше понять что и как делать. Не оставлен в стороне и вопрос выбора (и оптимизации) настроек дисковой системы для повышения производительности.

Наибольший же интерес, на мой взгляд, должны представлять первые две книги – изложенный материал позволяет гораздо лучше понять, как именно устроены дисковые системы IBM и как с ними нужно работать. Тем, кто впервые сталкивается с системами IBM, очень поможет описание термина “Storage Partitions”, который часто вызывает проблемы в понимании. Объясняется множество вопросов, которые могут возникнуть в процессе подбора конфигурации. Поэтому эти две книги полезны не только пользователям систем, но и пресейлам – правильно подобрать конфигурацию тоже бывает непросто. Отдельная глава посвящена RSM (Remote Support Manager), продукту который пока не слишком популярен на наших просторах, но ситуация должна постепенно меняться.

Администраторам будет интересно прочитать про процедуру обновления прошивок, конфигурацию коммутаторов и настройку СХД в связке с различными операционными системами (в т.ч. есть и пример настройки кластера Windows 2008 при загрузке с SAN). До недавнего момента в многочисленных книжках IBM встречалась рекомендация подключать контроллер A к одному коммутатору, а контроллер B – ко второму. Мне такая схема всегда казалась не очень правильной (хотя она и обеспечивала отказоустойчивость) так как при этой настройке, выход из строя коммутатора, обрыв кабеля от сервера к коммутатору или выход из строя адаптера в сервере гарантированно приводит к переносу LUN’а между контроллерами, что может вызвать проблемы производительности. Поэтому я всегда рекомендовал подключать каждый контроллер к каждому коммутатору и терпеливо объяснял свою позицию внимательным читателям документации. Сейчас же был приятно удивлен – теперь везде приводится рисунок с “правильным” подключением:

Можно найти и очень много подробных описаний по оптимизации настроек СХД для тех или иных приложений. Но отдельного упоминания заслуживает вопрос сайзинга, т.е. подбора конфигурации под имеющуюся (планируемую) нагрузку. Здесь и работа с монитором производительности в Storage Manager (Performance Monitor), и IBM Tivoli Storage Producivity Center for Disk. Детально объясняется работа с такой полезной утилитой для сайзинга как Disk Magic (впрочем, я не уверен что она доступна пользователям, но имеющие доступ на IBM Partnerworld могут ее оттуда скачать). Даже если доступа к утилите у Вас и нет, Вы можете собрать необходимые данные и отправить их интегратору, чтобы он провел для необходимый расчет и подобрал нужную конфигурацию, которая обеспечит должный “запас прочности”.

Так как упомянутые книги это пока только драфты, то читать их конечно нужно, но и следить за обновлениями тоже не помешает!

Читать дальше ...среда, 13 января 2010 г.

Общий доступ к дискам (Sanbolic Melio FS и другие)

С завидным постоянством вижу вот такого плана вопрос:

“Мы установили дисковую систему, создали один LUN, все настроили, подключили два сервера. На одном сервере файлы записываем, а на другом никаких изменений не видно. Да еще и ошибки какие-то странные. Что надо еще настраивать?”.

Причем, как это ни странно, технический уровень спрашивающих может быть очень разным, а вопрос один и тот же. А ведь, казалось бы, все очевидно: файловые системы (большинство), которые мы привыкли использовать (NTFS, EXT3, …) просто не умеют работать в таком “распределенном” режиме. Представьте, что на сервер А мы записали на диск файл, но каким образом об этом станет известно серверу B? Без специальной кластерной файловой системы, которая сообщит ему об этом – никак. И наиболее вероятным результатом (даже сравнительно короткого) такого “испытания” на обычной файловой системе будет полный ее крах. Поэтому даже и эксперименты проводить не стоит – работать не будет! А что тогда делать и нужно ли это вообще? В большинстве случаев (особенно если очень пристально посмотреть на задачу или заказчика :) ) такой функционал действительно оказывается ненужным и для совместного доступа к файлам достаточно использовать CIFS (в Windows) или NFS (в Linux). Но, тем не менее, существует и довольно много задач, где общий доступ к дисковому устройству если и не необходим, то очень важен. Как для более простой реализации, так и для лучшей производительности системы. Для того чтобы такой доступ обеспечить нам и нужна будет кластерная файловая система. Существует их довольно много, подавляющее большинство ориентировано на Linux/Unix (RedHat GFS, IBM GPFS, Lustre, HP Plyserve и т.п.), но и Windows не остался в стороне (Sanbolic MelioFS, HP Polyserve, IBM GPFS). Исторически решения под Linux использовались для HPC кластеров (и ряда других приложений), а под Windows в основном для обработки медиа-контента. Сейчас дисбаланс уже не так заметен – Windows работает на всех фронтах. Кроме того, все активнее внедряются системы виртуализации на базе Hyper-V в Windows Server 2008 и 2008 R2. И, если у основного конкурента (VMware) кластерная файловая система уже есть (VMFS), то в случае с Hyper-V нужно либо обходиться без нее, либо использовать сторонние продукты. Но даже и в случае с VMware разделяемая файловая система может очень пригодиться – например при использовании совместно с бесплатным VMware Server можно размещать образы виртуальных машин на общем дисковом ресурсе, что значительно упрощает миграцию и в разы снижает время простоя при сбоях.

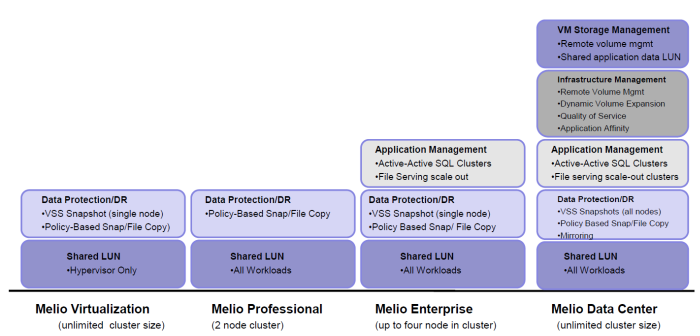

Сегодня более подробно я остановлюсь на решениях компании Sanbolic. Помимо кластерной файловой системы MelioFS, в портфель продуктов постепенно добавлялись и другие решения – это и система управления томами LaScala, и SILM, и AppCluster (о них немного ниже), а выбрать что же именно нужно купить, чтобы получить искомый результат, становилось все сложнее. И, если представители интегратора в большинстве случаев хорошо понимают что и для чего нужно, то объяснить клиенту, что ему нужна не одна лицензия за 2000$, но к ней еще нужно докупить две лицензии по 1500$, было в некоторых случаях сложно. В настоящее время ситуация существенно упростилась и предлагается всего 4 лицензии: Melio Virtualization, Melio Professional, Melio Enterprise и Melio Data Center. Благодаря этому выбор оптимального решения стал гораздо проще.

Все четыре продукта включают в себя (помимо кластерной файловой системы) систему управления томами (volume manager) LaScala. Поддержка страйпинга и конкатенации позволяет получить высокопроизводительный том необходимого объема. Также во все бандлы входит система SILM (Simple Information Lifecycle Manager), которая, на основе заданных пользователем политик, может перемещать файлы между различными системами хранения. Например, файлы, к которым не было обращения более 10 дней, будут перенесены на более медленную дисковую систему. Важно отметить, что поддерживается “смешанный” режим работы – данные могут располагаться не только на томах MelioFS, но и на любых других дисках (в том числе и локальных).

Melio Virtualization ориентирован на заказчиков, которые внедряют у себя Hyper-V или VMware Server, и позволяет получить всем серверам доступ к общей дисковой подсистеме (iSCSI или FC) для размещения на ней образов виртуальных машин. Благодаря поддержке технологий Quick и Live Migration, а также отсутствию ограничения на число серверов в кластере, актуальность данного решения фактически прямо пропорциональна числу физических серверов Hyper-V.

Второй, ориентированный на виртуализацию продукт - Melio Professional. Он предназначен для развертывания отказоустойчивого высокопроизводительного кластера системы динамической загрузки образов операционных систем на базе Citrix Provisioning Services. На общей файловой системе хранится как база данных, так и сами vDisk вместе с файлами кэшей записи. Нужно помнить, что данный бандл имеет ограничение на включение максимум двух узлов в кластер (а использовать меньше и смысла не имеет).

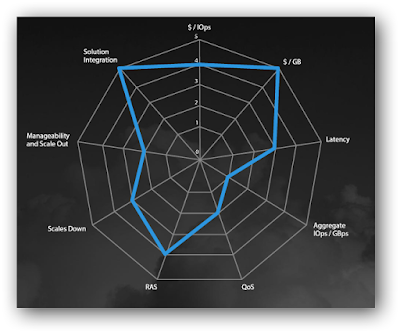

Два оставшиеся варианта лицензий уже не являются такими узкоспециализированными и предназначены для широкого круга заказчиков, чьи задачи не ограничиваются только виртуализацией. Melio Enterprise поддерживает совместную работу до 4х узлов в одном кластере и имеет ряд ограничений по сравнению с “топовой” версией Melio Data Center. В частности, нет поддержки зеркалирования (RAID1) и Quality of Service. Обе версии позволяют создавать высокопроизводительные кластеры файловых серверов, в том числе и с поддержкой балансировки нагрузки (NLB). Разумеется поддерживается DFS и ACL. Возможность динамического расширения файловой системы и томов позволяет избежать лишних остановок сервиса для обслуживания системы. По мере роста требований к файловым серверам можно добавлять как серверы, так и системы хранения в существующий кластер, увеличивая тем самым как суммарную емкость, так и производительность системы в целом:

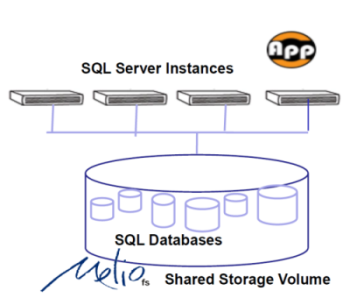

Также в состав обоих пакетов входит AppCluster Manager – средство управления active-active кластерами MS SQL, когда соответствующие базы данных размещены на разделяемой файловой системе. Конечно, это решение не позволяет (в силу архитектуры MS SQL) построить аналог Oracle RAC, но дает возможность обеспечить минимальное время переключения между серверами в кластере в случае сбоя, а также балансировать нагрузку между физическими машинами:

Для тех же кто использует Hyper-V есть еще зачастую весьма веская причина использования Enterprise или Datacenter версий – технология Pass-through I/O увеличивает производительность дисковой подсистемы так как не требуется оповещение остальных машин в Windows Failover кластере об операциях записи в виртуальных машинах.

Триальную двухнедельную версию можно получить, зарегистрировавшись на сайте Sanbolic. А купить и/или получить более подробную информацию, как обычно, можно у нас. :)

Читать дальше ...понедельник, 16 ноября 2009 г.

Бесплатный сыр (софт) без мышеловки.

Не так давно VMware объявила о доступности VMware vCenter CapacityIQ – плагина для vCenter, который дает возможность анализировать нагрузку на серверы, а также делать прогноз в стиле “что если”. Плагин является платным, но (как и для других продуктов VMware) можно скачать 60ти дневный триал. Схожие продукты были и у других компаний, например, VKernel поставляла (также платный) Modeler. Но вот на днях было объявлено, что теперь (по крайней мере до 31 декабря 2009г) данный продукт доступен совершенно бесплатно на неограниченное число хостов. Возможностей у Capacity Modeler достаточно, чтобы удовлетворить самые разные требования. Так что если нужно планировать увеличение нагрузки за счет добавления новых виртуальных машин, а бюджета на CapacityIQ уже нет, то решение от VKernel будет очень кстати. Конечно же, данная акция рассчитана прежде всего на привлечение клиентов к более “вкусным” (но уже не бесплатным) продуктам VKernel, но никто не мешает Вам ограничится только бесплатной (и от этого ничуть не менее полезной) частью.

Читать дальше ...вторник, 3 ноября 2009 г.

Еще немножко про Veeam

Я уже некоторое время назад писал про анонс Veeam Backup & Replication 4.0, теперь его можно совершенно спокойно скачать и попробовать (а те, кто уже купил и находится на поддержке – обновиться).

Кроме того, наткнулся на пару роликов про продукцию Veeam. Рекомендую посмотреть тем, кому лень читать – хотя и с прицелом в маркетинг, но довольно внятно рассказывается про возможности.

А тем, кто решил приобрести VMware vSphere Essentials (недорогой вариант на 3 двухпроцессорные машины), рекомендую обратить внимание на специальный бандл от Veeam – Veeam Essentials, в состав которого входят три продукта Backup & Replication, Reporter и Monitor и все это сразу на те же 6 сокетов. В результате, получается удобная в обращении инфраструктура и закрыты не только вопросы управления, но и резервного копирования.

Читать дальше ...четверг, 3 сентября 2009 г.

Veeam Backup & Replication 4.0

Что-то немного позавчерашние новости получаются, но все руки не доходят..

Буквально несколько дней назад была анонсирована новая версия Veeam Backup. Изменения во многом ориентированы на использование в vSphere:

- Поддерживается технология vStorage API, который пришел на смену VCB (VCB, впрочем также поддерживается). Поддержка vStorage необходима, например, для бэкапа FT виртуальных машин.

- Полностью поддерживаются thin-provisioned диски, что существенно может сократить время резервного копирования и восстановления.

- Поддерживается отслеживание измененных блоков, что также сокращает время инкрементального резервного копирования.

- Можно делать “горячую” репликацию дисков работающих VM на удаленную площадку.

- Полная поддержка PowerShell дает возможность всю работу “загнать” в скрипты.

- Логи теперь автоматически исключаются из бэкапов и репликации для сокращения времени и экономии трафика.

- Вместо того, чтобы на удаленную площадку посылать через плохой канал начальную реплику, теперь можно сделать ее локально и физически перевезти на удаленный сайт.

- Улучшенный функционал в плане управления заданиями (в т.ч. возможность временной отмены заданий).

Полный список изменений можно прочитать тут.

Благодаря возможности делать репликацию каждые несколько минут, мы получаем близкую к CDP защиту данных. Я и раньше всегда рекомендовал Veeam Backup совместно с VMware ESX/ESXi, но теперь это становится уже практически “must have”.

Читать дальше ...VMware ThinApp против…

Tolly Group на днях опубликовали новое сравнение: “Application Virtualization: VMware ThinApp 4.0 versus Microsoft App-V 4.5 CU1 and Citrix XenApp 5.0”. Указанное сравнение не включает тестирование производительности, а оценивает, что называется, общие впечатления: требования при установке продукта, развертывание клиентов, процесс “упаковки” приложений, предоставление on-line и off-line доступа к приложениям. С одной стороны, статья подготовлена по заказу VMware, поэтому довольно просто угадать лидера сравнений :) Кроме того, XenApp наверное не совсем корректно сравнивать с ThinApp – все-таки это продукты немного разных категорий, хотя возможность стриминга приложений есть и там, и там. С другой стороны, если интересует именно “упаковка” приложений для доступа как по сети, так и, например, с USB флэшек, то по простоте и универсальности обойти ThinApp пока никому из конкурентов не удается: максимально упрощен как сам процесс упаковки приложений (а главное, контроль доступа к приложениям), так и сам доступ со стороны клиента – не требуется ни установки, ни настройки никаких дополнительных приложений. Стоимость VMware ThinApp на текущий момент составляет 5000$ за комплект для 50ти пользователей и по 39$ дополнительно за каждого следующего пользователя (без учета стоимости поддержки).

Читать дальше ...среда, 29 июля 2009 г.

Лицензирование VMware vSphere

Почему то незаслуженно засунутая в глубину офф сайта страничка где описаны функциональные отличия редакций. Очень доступно и полезно. Ссылка.

Базовая страница про лицензии для VMware vSpehere. Upgrade/downgrade vi 3 etc.

VMware vSphere 4 Licensing guide – pdf.

PDF с полной таблицей всех функций и описанием в каких редакциях что есть. Зато очень подробно описан функционал того что есть в vSphere. Фактически – детальное сравнение редакций standart/advanced/enterprise/enterprise+. Ссылка.

Статья из KB VMware описывающая исключительно апгрейд с VI3 на vSphere. Ссылка.

Статья из KB VMware описывающая исключительно даунгрейд с vSphere на VI3. Ссылка.

Про Intel HT и лицензии на ядра – официального ответа не нашел. Есть тема на форуме VMware из неё можно сделать вывод, что HT за отдельное ядро не считается. Видимо точный ответ надо искать индивидуально в суппорте. Ссылка.

Читать дальше ...