Это очередное сообщение из разряда “старых новостей”, но по ряду причин добрался я до этих систем только сейчас. Пост получился длинным, поэтому прошу прощения за “много букв”.

Многие знают компанию Infortrend как производителя бюджетных дисковых систем (из разряда “один контроллер, набить любыми дисками и вперед”), а некоторые даже помнят SCSI RAID-контроллеры, которые ставились в пяти-дюймовый отсек.

Основанная в 1993 году компания изначально занималась только RAID-контроллерами, а потом пришла и к выпуску дисковым системам. Звезд с неба не хватают, но железки делают довольно стабильные и производительные (что немаловажно). Причем контроллеры их ставились не только в “свои” системы, но и поставлялись другим производителям, например, они использовались в системах DotHill SANnet, которые, в свою очередь, продавал под своим именем SUN.

Основанная в 1993 году компания изначально занималась только RAID-контроллерами, а потом пришла и к выпуску дисковым системам. Звезд с неба не хватают, но железки делают довольно стабильные и производительные (что немаловажно). Причем контроллеры их ставились не только в “свои” системы, но и поставлялись другим производителям, например, они использовались в системах DotHill SANnet, которые, в свою очередь, продавал под своим именем SUN.

Но похоже что сейчас соревноваться с множеством “нонейма” становится все сложнее и Infortrend решил выйти на новый уровень: в июне этого года общественности были представлены системы ESVA (Enterprise Storage Virtualized Architecture), призванные, как даже из названия понятно, занять место в новом (для Infortrend) сегменте рынка. Конечно и раньше двухконтроллерные системы некоторыми заказчиками ставились для важных приложений, но открытыми оставались много вопросов. Один из них - "время жизни” продукта: как долго после анонса о снятии с продаж будут доступны запчасти. Не менее важным является и вопрос замены вышедших из строя компонентов.

Какие же особенности у новых систем? Во-первых, все массивы архитектуры ESVA поставляются только с дисками, поэтому заказчику уже не нужно выбирать диски самому, потенциально рискуя “нарваться” на несовместимость. Хостовые интерфейсы либо FC (8Gbit), либо iSCSI (в настоящее время с портами 1Gbit, но совсем в недалеком будущем будут и модели с 10Gbit), “вертикальное” расширение (полками) достигается при помощи SAS интерфейса. Все компоненты дублированы (контроллеры, блоки питания, вентиляторы). Кэш контроллеров защищен батарейкой (BBU), но для систем с 3.5” дисками батарея не поддерживает кэш все время а служит для того, чтобы в случае проблем с питанием, произошел “сброс” содержимого кэша в энергонезависимую память (флэш-накопитель). На всю серию ESVA обещана пятилетняя доступность запчастей (уже после снятия конкретной модели с продаж). Вы скажете, что это конечно всё важные (очень важные) мелочи, но системы, нацеленные в “энтерпрайз” класс должны иметь и соответствующий функционал! А с функционалом у привычных Eonstor-ов всегда было негусто – вот только совсем недавно появились снапшоты (а у кого их сейчас-то нет?), да вот собственно и все возможности. И можно было бы ожидать каких-то косметических улучшений, но нет - архитектура ESVA действительно значительно превосходит все то, чем мог нас порадовать Infortrend раньше. Помимо буквально необходимой для систем такого класса синхронной и асинхронной репликации и клонов (а про снапшоты наверное и упоминать не нужно), появилась такая технология как “thin provisioning”. Я уже очень давно думаю, но не представляю как можно коротко и внятно перевести на русский язык этот термин. Смысл технологии в том, что хосту предоставляется LUN размером, скажем 20ТБ, но фактически на дисковой системе этот LUN занимает столько места, сколько на нем сейчас есть данных (фактически у нас даже может вовсе и не быть всех этих 20ТБ на системе хранения).

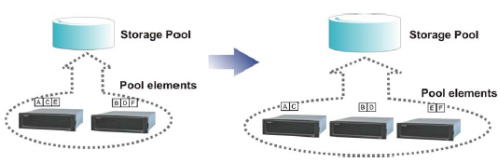

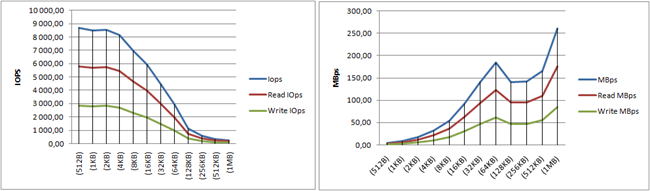

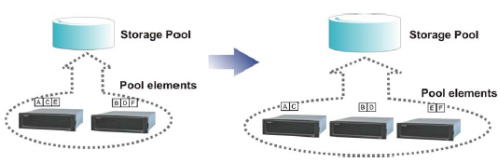

Но и это не главное – основная особенность новой линейки – “горизонтальное” масштабирование (как объема, так и производительности). Если в какой-то момент нам становится недостаточно имеющегося объема, мы конечно как обычно можем добавить еще одну полку с дисками, но когда нам недостаточно производительности, то, в случае использования традиционных систем, приходится переходить уже на новую СХД, приспосабливая имеющуюся под другие нужды. При этом, миграция данных с одной системы на другую – процесс болезненный и зачастую дорогостоящий. Более того, приходится не только останавливать приложения на время миграции, но и есть ненулевой шанс потерять данные и потом восстанавливать их из резервной копии, что только увеличивает общие затраты. В случае с ESVA такой головной боли нет – достаточно добавить еще одну систему и она включится в общий “пул” – данные автоматически будут перераспределены между системами и, в зависимости от числа узлов в таком кластере, общая производительность возрастает практически линейно. В один пул можно объединить до 12ти массивов ESVA, что дает суммарно 1344 диска.

Но и это не главное – основная особенность новой линейки – “горизонтальное” масштабирование (как объема, так и производительности). Если в какой-то момент нам становится недостаточно имеющегося объема, мы конечно как обычно можем добавить еще одну полку с дисками, но когда нам недостаточно производительности, то, в случае использования традиционных систем, приходится переходить уже на новую СХД, приспосабливая имеющуюся под другие нужды. При этом, миграция данных с одной системы на другую – процесс болезненный и зачастую дорогостоящий. Более того, приходится не только останавливать приложения на время миграции, но и есть ненулевой шанс потерять данные и потом восстанавливать их из резервной копии, что только увеличивает общие затраты. В случае с ESVA такой головной боли нет – достаточно добавить еще одну систему и она включится в общий “пул” – данные автоматически будут перераспределены между системами и, в зависимости от числа узлов в таком кластере, общая производительность возрастает практически линейно. В один пул можно объединить до 12ти массивов ESVA, что дает суммарно 1344 диска.

Излишне наверное говорить, что и объемы дисковых систем также объединяются (общий размер Virtual Pool может достигать 2PB) и уже нет той проблемы, когда есть две системы хранения, на одной системе осталось свободных 3ТБ, на другой - 2ТБ, а нам нужно для одного из хостов создать диск размером 4ТБ. В случае с ESVA после добавления второй системы, общий свободный доступный объем составит 5ТБ и можно создать том на 4ТБ (даже не используя thin provisioning).

Излишне наверное говорить, что и объемы дисковых систем также объединяются (общий размер Virtual Pool может достигать 2PB) и уже нет той проблемы, когда есть две системы хранения, на одной системе осталось свободных 3ТБ, на другой - 2ТБ, а нам нужно для одного из хостов создать диск размером 4ТБ. В случае с ESVA после добавления второй системы, общий свободный доступный объем составит 5ТБ и можно создать том на 4ТБ (даже не используя thin provisioning).

Если вдруг нам потребуется удалить систему из пула, то такое действие также возможно – можно дать соответствующую команду и данные будут перераспределены так, чтобы можно было произвести отключение одной из систем (если конечно на оставшихся достаточно свободного места).

Если вдруг нам потребуется удалить систему из пула, то такое действие также возможно – можно дать соответствующую команду и данные будут перераспределены так, чтобы можно было произвести отключение одной из систем (если конечно на оставшихся достаточно свободного места).

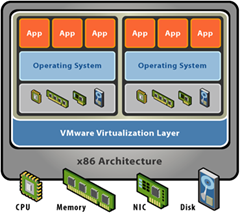

По сути своей предлагаемое Infortrend’ом решение является системой виртуализации СХД, которая находится в самой СХД, а не вне ее, как это реализовано например в IBM SVC, Falconstor NSS или HP SVSP. Конечно нельзя сказать, что это что-то совсем-совсем новое – довольно давно на рынке присутствуют системы EqualLogic (поставляются сейчас от имени Dell), которые тоже умеют масштабироваться горизонтально, однако они не могут быть расширены добавлением JBODов и в качестве хостового интерфейса имеют только iSCSI. Схожую реализацию можно наблюдать и в системах 3PAR, правда там уже нельзя объединить вместе несколько отдельных систем с целью повышения производительности или увеличения объема пула данных.

Несложно догадаться, что цена на массивы серии ESVA конечно же не та, что на Eonstor’ы, но тот функционал, который предоставляется, того стоит. Продажей этих систем занимаемся в том числе и мы, так что – милости просим!

Читать дальше ...