Почему администраторы сети нуждаются в полной видимости приложений

Эволюция межсетевого экрана

На протяжении многих лет роль межсетевого экрана неуклонно эволюционировала из защиты сетей от внешних взломов и атак в сторону большего внимания к тому, что внутри сети для выявления и устранения потенциальных рисков и обеспечения соответствия нормативным требованиям. Частью этой эволюции является реакция на тенденцию смещения акцента угроз в сторону вредоносных программ и вторжений, предназначенных для использования уязвимостей в приложениях, а не в самом периметре сети. Кроме того, этому смещению акцента также способствовали растущие обязательства по обеспечению разумного уровня защиты от нарушений и потери данных, а также оптимизации производительности сети.

Межсетевой экран следующего поколения (Next Generation Firewall, NGFW), по сути, был создан из необходимости обеспечить видимость и контроль над пользователями и их приложениями. NGFW работает уровнем выше, чем просто управление портами и протоколами как в более ранних межсетевых экранов с отслеживанием состояния на более высокие уровни в модели OSI для обеспечения осведомленности о приложениях и пользователях.

NGFW используют глубокую проверку пакетов (Deep Packet Inspection, DPI) для идентификации приложений и связывания их с пользователями или хостами в сети, чтобы администраторы могли осуществить соответствующий контроль. Например, очень полезно иметь возможность идентифицировать пользователей, использующих одноранговые приложения для совместного доступа к файлам, и блокировать их, контролируя при этом чрезмерный просмотр потоковых мультимедийных данных, при этом отдавая приоритет важным бизнес-приложениям, таким как система ERP, трафик VoIP и ПО CRM.

Как работает контроль приложений межсетевого экрана следующего поколения

Способ идентификации приложений NGFW заключается в сопоставлении логической структуры трафика с известными сигнатурами. Данный способ аналогичен распознаванию лица. Когда вы видите лицо человека, которое вы не знаете, вы сравниваете его с лицами людей из памяти, если вы получаете совпадение, вы знаете, с кем вы имеете дело, если вы не получаете совпадение, вы действительно не представляете, кто этот человек.

Контроль приложений работает точно так же. Некоторые приложения используют эквивалент имени, что облегчает их идентификацию, большинство же — нет, а некоторые из них даже придумывают свои способы пути, чтобы проскользнуть неизвестными.

Конечно, когда приложение идентифицировано, межсетевой экран может управлять приложением, используя traffic shaping, чтобы приоритизировать или заблокировать его. Но если совпадений нет, межсетевой экран понятия не имеет, с чем он имеет дело, и не контролирует его.

Проблемы с управлением приложениями межсетевого экрана следующего поколения

Как вы, наверное, можете себе представить, многие приложения не идентифицируются. Множество опасных приложений, которые обычно блокируются в большинстве организаций, такие как Клиенты BitTorrent, используют умные методы, чтобы постоянно изменять логическую структуру трафика и способ подключения, чтобы избежать обнаружения. Это похоже на то, как человек меняет цвет волос и добавляет усы, чтобы уклониться от распознавания лица.

Другие приложения используют шифрование, чтобы избежать обнаружения, которое во многом похоже на человека, носящего лыжную маску. Так же многие другие приложения будут притворяться браузером, чтобы они могли проходить через межсетевой экран без контроля. Это аналогично плохому человеку, маскирующемуся под хорошо известную знаменитость. А потом появляются приложения, которые недавно изменились или являются одноразовыми, пользовательскими или просто слишком неясными, чтобы иметь соответствующий образец. Это как люди, у которых нет недавних фотографий в файле.

На самом деле, поскольку NGFW постоянно улучшают свои возможности по обнаружению нежелательных приложений и управлению ими, эти приложения, в свою очередь, постоянно улучшают свои способности избегать обнаружения. Конечным результатом является то, что большая часть трафика проходит через современный межсетевой экран, оставаясь неизвестной, неидентифицируемой или просто слишком универсальной для классификации или контроля.

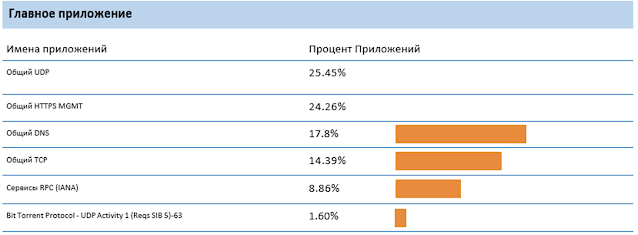

Выглядит ли ваш отчет App Control таким образом?

Насколько велика проблема?

Стремясь лучше понять, насколько распространена эта проблема, Sophos недавно провел опрос организаций среднего размера, чтобы определить, какая часть трафика их приложений остается неопознанной и неконтролируемой:

- Почти 70% организаций имеют межсетевой экран следующего поколения или UTM со слежкой за приложениями

- В среднем 60% трафика идет неопознанным... и многие организации сообщили, что до 90% их трафика приложений не идентифицировано

- 82% по праву обеспокоены опасностями, которые вызывают неопознанные приложения

- 65% были обеспокоены тем, какое влияние это может оказать на производительность их сети

- 40% были обеспокоены потенциальной юридической ответственностью

Основные проблемы, связанные с отсутствием видимости приложений в настоящее время:

С чем связаны ваши проблемы с неопознанным сетевым трафиком?

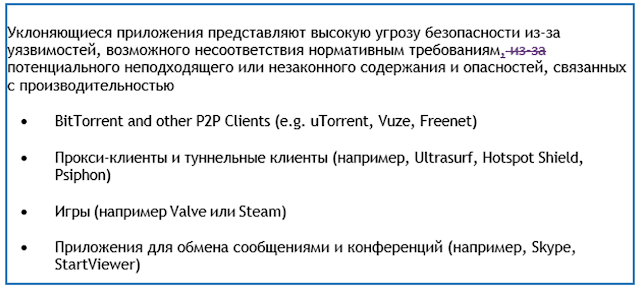

Лучшие уклоняющиеся и неопознанные приложения

К сожалению, вам практически невозможно узнать, запущено ли какое-либо из этих приложений в вашей сети, потому что сигнатуры межсетевого экрана в большинстве случаев просто не найдут совпадения.

В дополнение к этим приложениям, существует бесчисленное множество приложений, которые являются как доброкачественными, так и потенциально нежелательными, которые прибегают к использованию общих HTTP и HTTPS соединений для связи через межсетевой экран, учитывая то, что почти каждая организация использует свой брандмауэр для доступа в Интернет на портах 80 и 443. В отчетах они будут просто отображаться как HTTP, HTTPS, SSL, Web Browsing и как другие категории, которые не являются информативными.

И, что наиболее важно, существуют приложения, ERP-решения, CRM-программное обеспечение и другие для бизнеса, которые могут быть уникальными для вашей организации, они остаются незамеченными и потенциально могут быть подавлены под тяжестью веб-серфинга и другого нежелательного трафика приложений просто потому, что они недостаточно популярны, чтобы иметь сигнатуру.

К счастью, есть довольно элегантное решение этой проблемы.

Решение

В то время как межсетевые экраны следующего поколения (NGFW) должны полагаться на глубокую проверку пакетов, сопоставление образцов и сигнатур, чтобы попытаться идентифицировать приложения во время их прохождения по сети, узлы сети находятся в уникальной позиции, которая позволяет абсолютно точно знать, какие именно исполняемые файлы генерируют весь сетевой трафик.

Отсюда вытекает довольно очевидный вопрос, как соединить конечные точки с межсетевым экраном, чтобы поделиться этой информацией. К счастью, в Sophos есть технология, позволяющая просто и эффективно реализовать это: Synchronized Security.

Sophos Synchronized Security — это революционно новый подход к ИТ-безопасности, который позволяет продуктам по обеспечению безопасности обмениваться информацией и работать вместе, обмениваясь информацией в реальном времени, для получения непревзойденной защиты и автоматического реагирования на опасности.

Одна из первых инноваций Synchronized Security, Security Heartbeat™, соединяет управляемые конечные точки Sophos Central с Sophos XG Firewall для совместного использования состояния конечных точек, обеспечивая мгновенную идентификацию систем, подверженных риску. При обнаружении опасности в конечной точке или брандмауэре индикаторы выдают предупреждения в режиме реального времени, сразу же идентифицируя компьютер, пользователя и процесс. И, возможно, самое важное преимущество Security Heartbeat заключается в том, что межсетевой экран может включать состояние конечных точек в правилах, обеспечивая автоматический ответ: либо ограничивая доступ, либо полностью изолируя скомпрометированную систему до тех пор, пока ее не удастся очистить. Это сокращает время реагирования с часов до секунд и помогает снизить риск распространения инфекций на другие части сети.

Еще одно нововведение Synchronized Security — Synchronized App Control. Как следует из названия, Synchronized App Control использует уникальную экосистему Synchronized Security компании Sophos для эффективного и элегантного решения проблемы с выявлением неизвестного, скрывающегося или пользовательского трафика приложений в сети. Синхронизированный App Control использует возможности обмена информацией с Sophos Endpoints для определения источника неопознанного трафика приложений в сети, эффективно удаляя эту завесу, покрывающую сети сегодня.

Synchronized App Control в действии

Это первый крупный прорыв в области видимости и управления сетевыми приложениями с момента создания межсетевого экрана следующего поколения.

Когда управляемая Sophos Central конечная точка подключается к сети с помощью XG Firewall, она устанавливает соединение с Security Heartbeat™ для совместного использования состояния работоспособности, безопасности и телеметрии. Кроме того, теперь конечная точка также будет использовать это подключение для совместного использования идентификатора всех сетевых приложений с межсетевым экраном.

Если XG Firewall не может определить приложение с помощью традиционных методов сигнатур, поскольку приложение является маскирующимися, настраиваемым, новым или использует универсальное соединение, информация о приложении, предоставляемая конечной точкой, будет использоваться для его идентификации, классификации и контроля.

Если это возможно, то приложения, информация о которых предоставляется конечной точкой, автоматически классифицируются. Это автоматически накладывает на новое идентифицированное и приложение политики, которые уже применяются на межсетевом экране.

Например, маскирующийся клиент BitTorrent автоматически назначается в категорию приложений Peer-to-Peer. Если NGFW использует политику управления приложениями для блокирования Peer-to-Peer приложений, новый трафик BitTorrent будет автоматически заблокирован без вмешательства сетевого администратора.

Преимущества:

Идентификация неизвестных приложений

Synchronized App Control показывает все приложения, которые в настоящее время невидимы в сети, включая все новые приложения, а также приложения туннелирования, прокси и VPN, которые часто используют шифрование для обхода управления брандмауэром — создавая слепые зоны, а так же различные риски связанные производительностью и безопасностью. Если существуют политики для блокирования или формирования трафика этих приложений, новые, попадающие в эту категорию, будут автоматически подвергаться таким же политикам. Кроме того, соответствующие пользователи и хосты будут легко идентифицированы, что позволит в соответствующих случаях проводить вмешательство.

Определение приоритетов приложений

Synchronized App Control мгновенно определит пользовательские приложения для бизнеса, которые полностью невидимы для текущего брандмауэра, такие как финансы, CRM, ERP, производство и другие сетевые приложения, важные для организации. Впервые Synchronized App Control предоставляет возможность применять политики формирования трафика и QoS, чтобы гарантировать, что критически важные приложения получат соответствующий приоритет и оптимальную производительность.

Управление уклоняющимися приложениями

Synchronized App Control автоматически обнаружит все приложения, которые постоянно меняют способ подключения и связи, чтобы избежать обнаружения и управления. По сути, синхронизированный App Control раз и навсегда прекращает эту тактику. Независимо от того, насколько уклончивыми будут эти приложения, они не смогут полностью избежать Synchronized App Control.

Какие продукты Sophos необходимы:

Sophos предоставляет полную экосистему продуктов ИТ-безопасности, которые просто интегрируются для обеспечения синхронизированной безопасности. Security Heartbeat™ и Synchronized App Control, а также все дополнительные функций безопасности, предоставляют видимость и контроль, которые не могут быть проще.

Как минимум, требуется межсетевой экран Sophos XG и Intercept X, но оба продукта могут быть развернуты вместе с другими системами ИТ-безопасности в дополнение к ним, чтобы обеспечить комплексную безопасность без прерывания работы..

Межсетевой экран Sophos XG может быть развернут в паре с существующим межсетевым экраном, либо в качестве основного межсетевого шлюза.

Он также может работать только в режиме отчетов и видимости, когда XG Firewall подключен к зеркальному порту коммутатора в режиме обнаружения (также известном как режим TAP).

На конечной точке может быть развернут Intercept X вместе с существующим AV-решением, или вы можете выбрать Sophos Central Endpoint Advanced для полной защиты конечных точек. Оба продукта Synchronized Security и XG Firewall поддерживаются на платформах Windows и Mac.

Итог

Межсетевой экран следующего поколения (NGFW) не могут выполнить свою заявленную роль и идентифицировать все приложения.

Существует неотъемлемое ограничение эффективности методов обнаружения приложений на основе сигнатур, что означает, что большая часть трафика приложений в современных сетях остается неопознанной и неконтролируемой.

Это большая и серьезная проблема. Она создаёт риски, связанные с безопасностью, производительностью и исполнением.

К счастью, существует эффективное решение: Synchronized App Control,использует уникальное соединение Sophos Security Heartbeat™ между конечными точками под управлением Sophos Central и XG Firewall для полного обмена информацией о сетевых приложениях.

XG Firewall с Synchronized App Control позволяет автоматически идентифицировать, классифицировать и контролировать весь неизвестный трафик приложений в сети. Это крупный прорыв в области видимости и управления сетью, который делает устаревшими все другие межсетевые экраны следующего поколения.